8.2大脑与神经网络

在人工智能的世界中,神经网络这个词频频出现,它的灵感来自人脑的神经系统。尽管现代的人工神经网络与生物神经元在细节上有很大不同,但两者之间的类比依然值得探讨。

8.2.1人脑中的神经元

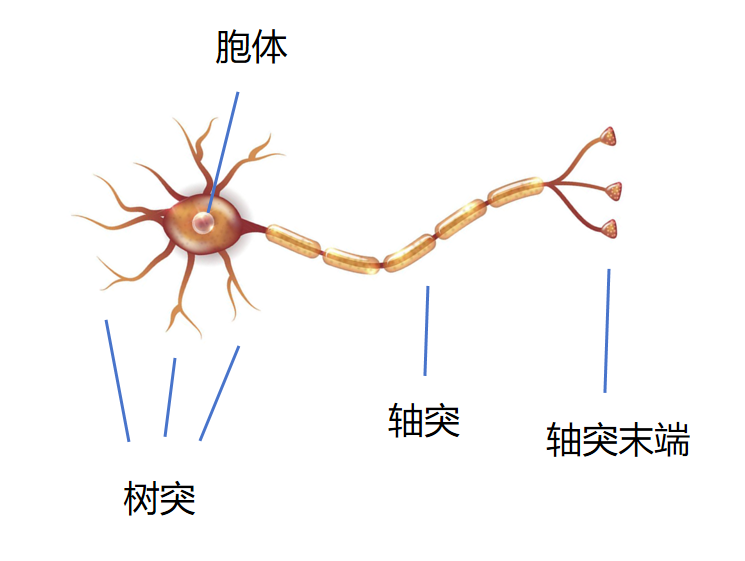

神经元是人脑中的基本单元,每个神经是一个信息处理和传递的节点。它主要由以下几个部分组成:

树突 接收其它神经元的信号。 胞体 神经元的计算中心,负责处理来自其他神经元的输入信号,并生成神经元的输出。输入分为两个状态,不激活(0)和激活(1)。 轴突 将本神经元的输出连接到其他神经元。

树突接收的信号相当于逻辑回归的输入,胞体相当于线性回归和激活函数,轴突将激活值传递,作为其他逻辑回归的输入。

一个神经元接收其它神经元的输入,然后经过自己的处理,决定要不要激活输出,也就是释放电信号给其他神经元。这和一个逻辑回归非常类似,逻辑回归接收多个输入,然后考虑多个输入的权重,最后经过Sigmoid激活函数,将输出映射到0-1之间。0代表不激活,1代表激活。

8.2.2神经网络

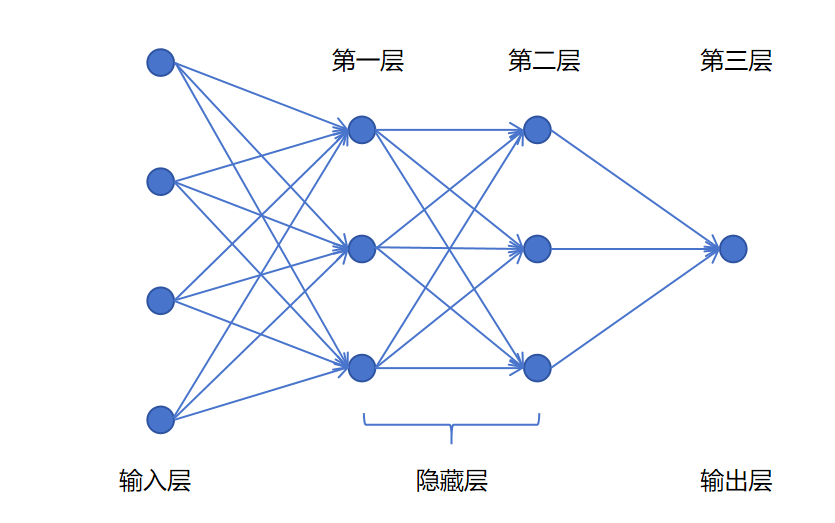

在深度学习的神经网络里,一般按层进行划分。整体上神经网络会被分为输入层,隐藏层,和输出层。输入层就是原始特征,输出层就神经网络最终的输出。除了输入层和输出层,剩下的层都是隐藏层。

我们计算神经网络的层数时,是不计算输入层的,因为输入层是特征,没有需要学习训练的参数。像上图中就是一个三层的神经网络。

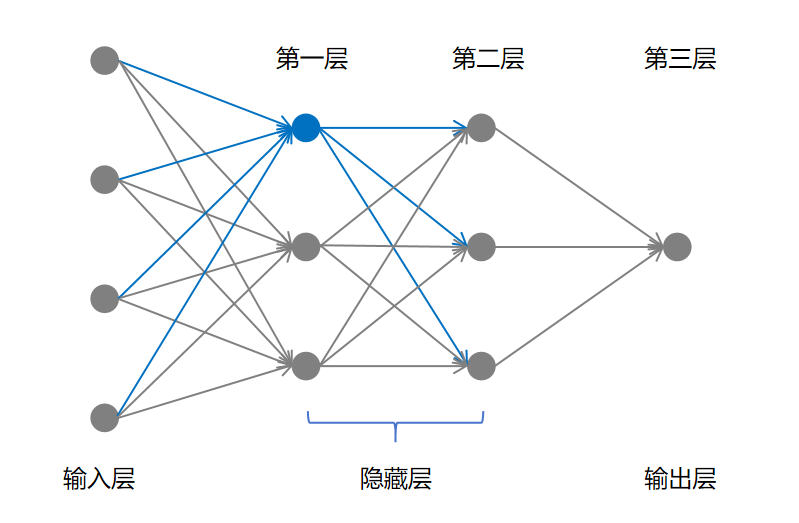

除了输入层,其他层的每一个圆点,都代表一个神经元。你现在可以简单的认为一个神经元就是一个逻辑回归。比如第一层的第一个神经元,它接入输入层的4个特征。然后经过逻辑回归,产生一个输出,同样的输出又作为多份输入进入第二层的所有神经元。

上一节,我们讲从逻辑回归到神经网络,中间只有一层隐藏层来抽取高级特征,不难想象,你可以在这些高级特征的基础上继续抽取更高级特征,这样我们就可以定义任意层的隐藏层。

神经网络中的一层我们叫做线性层(Linear Layer),因为其中每个神经元都是一个线性回归加上激活函数。或者叫做全连接层、稠密层(Dense Layer),因为每一层的每个神经元都和前一层的每个神经元进行连接,所以叫做全连接、稠密连接。

8.2.3深度神经网络

严格意义上说,只要隐藏层大于1层的神经网络都可以叫做深度神经网络。神经网络这个技术最早可以追述到1943年,几起几落,直到有了“深度学习”这个高深的名字后,才得以出圈,被社会广泛认知。

当然深度学习的兴起不光是因为一个好的名字,还有以下原因:

- 神经网络因为架构设计统一和可扩展,你可以增加任意隐藏层,每一层可以设计任意神经元。从而可以应对任意复杂规模的问题。

- 互联网、移动设备、社交媒体的普及,世界产生了海量数据,传统机器学习算法在海量数据面前都表现出了欠拟合,只有神经网络可以通过增加深度,不断提升模型的性能。

- GPU技术的发展,特别适合神经网络里的大量矩阵计算。加快了神经网络的训练速度。