12.1 自然语言处理的进化之路

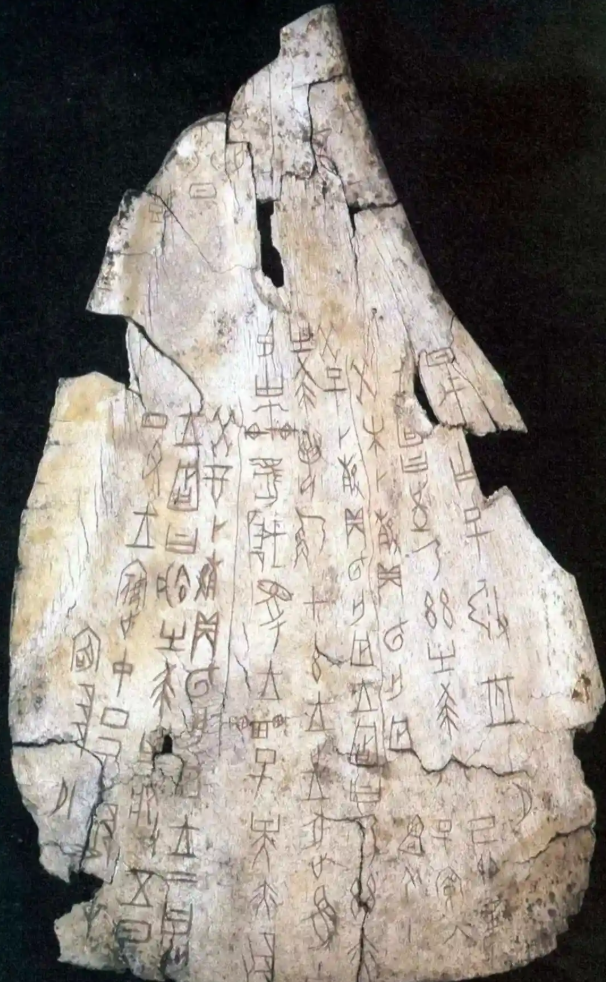

自然语言,从远古时期的甲骨文,到今天我们在互联网上的留言,一直作为人类智慧的载体,记录着人类的思考和对自然世界的认识。长久以来让计算机理解人类自然语言一直让科学家既着迷又挫败。在人工智能征服表格数据和图像识别的高地后,自然语言处理( Natural Language Processing, NLP)才在近十几年迎来真正的爆发。回望这条探索之路,充满了曲折的历程。

还记得当卷积神经网络在图像分类,目标检测领域出现突破进展时。NLP的研究人员当时沮丧的抱怨,图像分类,目标检测这些视觉任务太简单,三岁小孩,或者动物都可以完成。而且一个图片里包含了所有必要的信息。但是文本蕴含的内容可能远在文本在外。比如“色即是空”只是简单4个字,但是它包含的内容并不是每个人都明白。

但也正是NLP任务的困难,让大语言模型取得突破后,爆发出了前所未有的能量,对世界带来的变革远大于计算机视觉任务的突破。下边我们就来看人类是如何征服NLP这个难题的。

12.1.1 规则之困:语法迷宫的碰壁(1950s-1980s)

计算机科学诞生之初,科学家们满怀信心地试图用逻辑规则“教会”计算机理解语言。主导思想清晰而直接:句子由词汇通过语法规则组合而成,只要精确建模词法(构词、词性)和句法(句子结构),计算机就能破解语言密码。

然而,二十多年的努力几乎没有取得什么有价值的进展,主要是以下几个原因:

歧义无处不在:经典例子“中国队大胜美国队”与“中国队大败美国队”,规则系统如何理解“胜”与“败”这对反义词在此竟指向同一结果(中国队赢)?这揭示了词汇语义和语境对理解的极端重要性,远非简单规则可以捕捉。

结构嵌套难解:如“一行行行行行”(一行行,行行行。指一个行业干好了,各个行业都可以干好。),其含义依赖多音字和深层结构,规则系统难以精确定义其解析路径。

规则爆炸失控:人类语言充满例外、习语和动态变化,穷举所有规则并处理其冲突成为不可能的任务。

这条基于符号逻辑和人工编写规则(如早期的ELIZA聊天机器人、SHRDLU积木世界系统)的道路,最终被证明是一条死胡同。它无法处理真实世界语言的丰富性、模糊性和创造性。

12.1.2 统计革命:数据驱动的曙光(1980s末-2000s初)

70年代孕育了利用统计和概率解决NLP问题的思想火花,但真正的突破发生在80年代末至90年代初。研究者们转向了概率和统计的视角,提出了一个革命性的观点:语言的规律隐藏在海量文本数据本身之中。

核心范式是统计语言模型,它通过分析词序列在大规模语料库中出现的频率来估算概率。模型的目标是根据统计,预测下一个词出现的可能性。比如通过对海量文本的统计,当出现“我爱”这两个连续的字的时候,接下来出现“你”的概率为0.1,出现“玩”的概率为0.03,等等,给每个字分配一个概率。这一看似简单的转变却带来了立竿见影的效果:

机器翻译飞跃:基于词或短语共现统计的模型(如IBM模型)显著提升了翻译流畅度。

语音识别实用化:将声学模型与统计语言模型结合,大幅提高了识别准确率。

词性标注与基础任务:基于概率的方法在词性标注、命名实体识别等任务上表现远超规则系统。

统计方法第一次让NLP系统能够从真实语言数据中“学习”模式,处理语言的模糊性,迈向了实用化。

12.1.3 神经网络崛起:深度理解的质变(2000s中-2010s末)

统计方法虽有成效,但特征工程复杂且难以捕捉长距离依赖和深层语义。机器学习的深化,尤其是深度学习的兴起,开启了NLP的新纪元。

关键里程碑包括:

神经语言模型(NNLM):Bengio等人在2003年提出,用神经网络学习词的分布式表示(词向量/嵌入),如Word2Vec、GloVe。词不再是孤立的符号,而是在向量空间中具有语义关联的点。比如土豆和马铃薯的语义向量在向量空间中就几乎重合。而土豆和汽车的距离就很远。

循环神经网络(RNN/LSTM/GRU):引入记忆单元处理序列数据,能更好地建模上下文信息,在文本生成、情感分析等任务上表现出色。

Transformer的横空出世(2017):Google提出的Transformer架构彻底抛弃了RNN的顺序处理,依靠自注意力机制(Self-Attention),实现了对输入序列中所有元素关系的并行计算和高效建模。Transformer在捕捉长距离依赖和并行训练效率上的巨大优势,为后续NLP技术的爆发奠定了基础。

神经网络让模型具备了更强的特征自动提取能力和语义理解潜力。

12.1.4 大语言模型时代:通用智能的曙光(2020s-)

Transformer如同一座超级引擎,当它与海量数据和巨量算力结合时,催生了大语言模型(LLM) 的奇迹。

以ChatGPT为代表的大模型震撼了世界,LLM不再局限于特定NLP任务(如翻译、问答)。它还展现出强大的泛化能力、上下文学习能力(In-Context Learning) 和指令遵循能力(Instruction Following),能撰写创意文本、编写调试代码、进行复杂推理等。传统的NLP任务(分类、翻译、摘要、生成)被统一到一个模型。并且它的能力超越了NLP任务,展现出了解决数学、逻辑乃至跨模态(图文)问题的潜力,成为通向通用人工智能(AGI) 道路上最耀眼的灯塔。